Os pesquisadores do MIT compilaram um conjunto de dados que captura o comportamento detalhado de um sistema robótico, empurrando fisicamente centenas de objetos diferentes. Usando o conjunto de dados – o maior e mais diversificado do gênero -, os pesquisadores podem treinar robôs para “aprender” impulsionando dinâmicas que são fundamentais para muitas tarefas complexas de manipulação de objetos, incluindo reorientar e inspecionar objetos e cenas desorganizadas.

Para capturar os dados, os pesquisadores projetaram um sistema automatizado composto por um braço robótico industrial com controle preciso, um sistema de rastreamento de movimento 3D, câmeras tradicionais e de profundidade e software que une tudo. O braço empurra objetos modulares que podem ser ajustados para distribuição de peso, forma e massa. Para cada push, o sistema captura como essas características afetam o push do robô .

O conjunto de dados, chamado “Omnipush”, contém 250 itens diferentes de 250 objetos, totalizando aproximadamente 62.500 itens exclusivos. Já está sendo usado pelos pesquisadores para, por exemplo, criar modelos que ajudem os robôs a prever onde os objetos chegarão quando forem empurrados.

“Precisamos de muitos dados ricos para garantir que nossos robôs possam aprender”, diz Maria Bauza, uma estudante de graduação do Departamento de Engenharia Mecânica (MechE) e primeira autora de um artigo descrevendo Omnipush que será apresentado na próxima Conferência Internacional sobre Robôs e sistemas inteligentes. “Aqui, estamos coletando dados de um sistema robótico real, e os objetos são variados o suficiente para capturar a riqueza dos fenômenos de empurrão. Isso é importante para ajudar os robôs a entender como o empurrão funciona e para traduzir essas informações para outros similares. objetos no mundo real “.

O Omnipush baseia-se em um conjunto de dados semelhante, construído no Laboratório de Manipulação e Mecanismos (MCube) de Rodriguez, Bauza e outros pesquisadores que capturaram o envio de dados em apenas 10 objetos. Depois de tornar público o conjunto de dados em 2016, eles coletaram feedback dos pesquisadores. Uma queixa era a falta de diversidade de objetos: os robôs treinados no conjunto de dados lutavam para generalizar as informações para novos objetos. Também não havia vídeo, o que é importante para visão por computador, previsão de vídeo e outras tarefas.

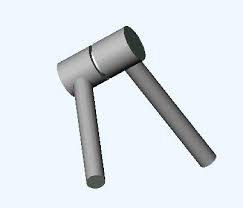

Para o novo conjunto de dados, os pesquisadores utilizam um braço robótico industrial com controle preciso da velocidade e posição de um empurrador, basicamente uma haste de aço vertical. À medida que o braço empurra os objetos, um sistema de rastreamento de movimento “Vicon” – usado em filmes, realidade virtual e para pesquisas – segue os objetos. Há também uma câmera RGB-D, que adiciona informações detalhadas ao vídeo capturado.

A chave estava na construção de objetos modulares. As peças centrais uniformes, feitas de alumínio, parecem estrelas de quatro pontas e pesam cerca de 100 gramas. Cada peça central contém marcadores no centro e nos pontos, para que o sistema Vicon possa detectar sua pose dentro de um milímetro.

Smaller pieces in four shapes—concave, triangular, rectangular, and circular—can be magnetically attached to any side of the central piece. Each piece weighs between 31 to 94 grams, but extra weights, ranging from 60 to 150 grams, can be dropped into little holes in the pieces. All pieces of the puzzle-like objects align both horizontally and vertically, which helps emulate the friction a single object with the same shape and mass distribution would have. All combinations of different sides, weights, and mass distributions added up to 250 unique objects.

For each push, the arm automatically moves to a random position several centimeters from the object. Then, it selects a random direction and pushes the object for one second. Starting from where it stopped, it then chooses another random direction and repeats the process 250 times. Each push records the pose of the object and RGB-D video, which can be used for various video-prediction purposes. Collecting the data took 12 hours a day, for two weeks, totaling more than 150 hours. Humans intervention was only needed when manually reconfiguring the objects.

Os objetos não imitam especificamente nenhum item da vida real. Em vez disso, foram projetados para capturar a diversidade de “cinemática” e “assimetrias de massa” esperadas para objetos do mundo real, que modelam a física do movimento de objetos do mundo real. Os robôs podem então extrapolar, digamos, o modelo físico de um objeto Omnipush com distribuição desigual de massa para qualquer objeto do mundo real com distribuição semelhante de peso desigual.

Em um experimento, os pesquisadores usaram o Omnipush para treinar um modelo para prever a pose final de objetos empurrados, considerando apenas a pose inicial e a descrição do empurrão. Eles treinaram o modelo em 150 objetos Omnipush e o testaram em uma porção de objetos retida. Os resultados mostraram que o modelo treinado por Omnipush era duas vezes mais preciso que os modelos treinados em alguns conjuntos de dados semelhantes. Em seu artigo, os pesquisadores também registraram parâmetros de precisão que outros pesquisadores podem usar para comparação.

Como o Omnipush captura vídeo dos pushes, um aplicativo em potencial é a previsão de vídeo. Um colaborador, por exemplo, agora está usando o conjunto de dados para treinar um robô para essencialmente “imaginar” empurrando objetos entre dois pontos. Após o treinamento no Omnipush, o robô recebe dois quadros de vídeo, mostrando um objeto em sua posição inicial e final. Usando a posição inicial, o robô prevê todos os futuros quadros de vídeo que garantem que o objeto atinja sua posição final. Em seguida, ele empurra o objeto de uma maneira que corresponda a cada quadro de vídeo previsto, até chegar ao quadro com a posição final.

Fonte da Matéria: Institute of Technology

Faça um comentário